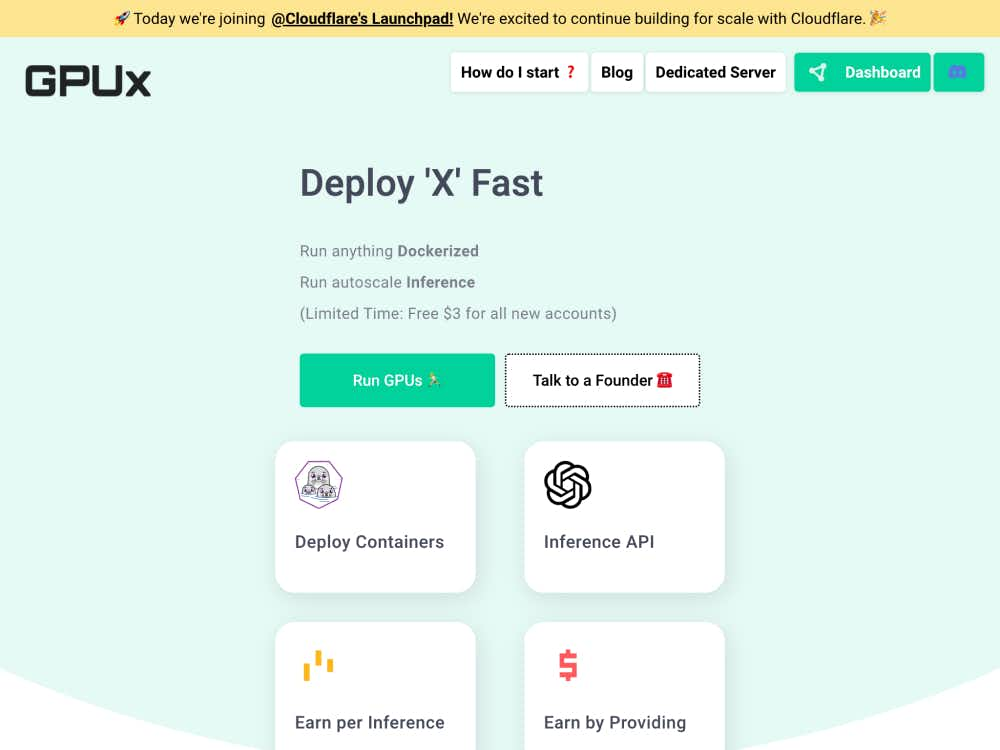

GPUx

GPUx offre une inférence sans serveur ultra-rapide pour les modèles d'IA tels que Stable Diffusion et Whisper. Déployez instantanément des IA basées sur GPU grâce à un démarrage à froid en une seconde, au partage pair à pair et à la prise en charge des modèles privés.

À propos de GPUx

Déployez des modèles d'IA à une vitesse fulgurante

GPUx est une plateforme d'inférence GPU sans serveur conçue pour simplifier et accélérer le déploiement de l'IA. Que vous utilisiez Stable Diffusion, ESRGAN, Alpaca ou Whisper, GPUx vous permet de lancer des modèles en quelques secondes sans gestion d'infrastructure.

Démarrage à froid en 1 seconde pour une IA instantanée

Le temps est un facteur crucial lors du déploiement d'applications d'IA. GPUx minimise la latence grâce à un démarrage à froid d'une seconde, garantissant ainsi la disponibilité quasi instantanée de votre modèle. Idéale pour les environnements de production ou le prototypage rapide, cette vitesse représente un véritable atout pour les développeurs et les équipes qui privilégient l'IA.

Comment fonctionne GPUx

Inférence GPU sans serveur

GPUx propose un modèle sans serveur qui déploie dynamiquement des instances GPU uniquement en cas de besoin. Ce modèle réduit les coûts tout en offrant une puissance de calcul haute performance pour les tâches d'inférence. Des modèles comme Stable Diffusion XL ou Whisper peuvent être appelés via de simples requêtes API, sans aucune surcharge.

Partage de modèles pair à pair

Les organisations peuvent vendre l'accès à leurs modèles privés via GPUx. Cela crée un marché pour l'inférence GPU et permet aux équipes de monétiser leurs charges de travail d'apprentissage automatique tout en conservant le contrôle.

Caractéristiques principales

Exécuter des modèles d'IA populaires

GPUx prend en charge divers modèles d'apprentissage automatique largement utilisés :

- StableDiffusionXL for high-quality image generation

- ESRGAN for image upscaling

- Whisper for speech-to-text transcription

- Alpaca for conversational AI

Prise en charge de l'accès au volume et de la lecture/écriture

Pour les modèles nécessitant un accès persistant aux données, GPUx prend en charge les volumes de lecture/écriture. Il est ainsi idéal pour les pipelines complexes, notamment ceux impliquant des E/S basées sur des fichiers ou des points de contrôle de modèles.

Environnement favorable aux développeurs

GPUx propose des outils en ligne de commande, une intégration GitHub et des exemples d'utilisation sur son blog pour faciliter la prise en main par les développeurs. La plateforme gère l'orchestration, vous permettant ainsi de vous concentrer sur les performances et le déploiement de vos modèles, sans avoir à vous soucier de la gestion des GPU.

Cas d'utilisation

Inférence rapide pour l'IA générative

Exécutez des modèles de conversion texte-image en quelques secondes grâce à Stable Diffusion XL. Idéal pour les outils créatifs, le prototypage visuel et les plateformes de génération d'images.

Transcription du discours

Déployez des modèles Whisper pour la transcription audio en temps réel ou par lots. Idéal pour créer des applications de reconnaissance vocale sans les coûts ni la complexité liés à la maintenance de serveurs GPU.

Mise à niveau et amélioration

Utilisez ESRGAN pour améliorer la qualité vidéo ou image. GPUx permet à ces améliorations de s'exécuter de manière fluide dans une configuration sans serveur, ce qui la rend idéale pour les flux de production multimédia.

Démonstrations en direct et expérimentation

Grâce à un accès instantané aux modèles, les développeurs peuvent itérer et déployer rapidement des démos, ce qui permet une expérimentation plus rapide sans avoir à provisionner d'infrastructure GPU.

Conçu pour les équipes d'IA modernes

GPUx est plébiscité par un nombre croissant d'équipes souhaitant déployer l'IA rapidement, efficacement et en toute maîtrise. Que vous soyez une startup ou une grande entreprise, la plateforme s'adapte à vos besoins, vous offrant une évolutivité sans complexité.